- Home

- Chi siamo

- Chi siamo – il laboratorio

- Iscriviti alla newsletter

- Il Manifesto di Carteinregola

- Le nostre regole

- Rete di Carteinregola

- Le iniziative di Carteinregola dal dicembre 2020

- Tutte le nostre iniziative

- Fatti sentire! Impariamo a usare gli strumenti di comunicazione

- Censimento

- Piediperterra

- Piediperterra a Dragona e Dragoncello

- 1. Parco del Drago: appunti per una introduzione storica

- 2. Dragoncello: storia del Parco del Drago, Convenzione urbanistica PRU e progetti

- 3. Storia di Dragona

- 4. Dragona: il Museo D. Agostinelli

- 5. Dragona: il Punto Verde Qualità

- 6. Dragona: La stazione Acilia sud Dragona

- 7. Dragona – Dragoncello: Dorsale mare Tevere

- 8. Progetto Casale Dragoncello

- Piediperterra a San Lorenzo – Municipio II Roma

- Piediperterra a Testaccio

- Piediperterra a Casal Bertone – 5 luglio 2018

- Piediperterra 1

- Piediperterra 2 a Morena

- Spiazmoli! Piediperterra all’EUR 3- Spiazziamoli! IL PERCORSO

- Piedi per terra al Torrino sud il 20 gennaio 2017

- Piediperterra a Primavalle -28 aprile 2018

- Piediperterra a Dragona e Dragoncello

- Diario Presidio Campidoglio 2012-2013

- Dieci parole dell’ urbanistica

- Rassegna stampa

- Laboratorio

- La Mappa

- Calendario

- Istituzioni

- ISTITUZIONI

- Governo Italiano

- ROMA CAPITALE

- La consiliatura Gualtieri dal 2021

- Deliberazioni dell’Assemblea Capitolina dal 2021

- Deliberazioni della Giunta Gualtieri dal 2021

- Roberto Gualtieri Sindaco

- La Giunta Capitolina Gualtieri 2021

- Silvia Scozzese Vicesindaco e Assessore al Bilancio

- Sabrina Alfonsi, Assessore ai Rifiuti, Ambiente e Agricoltura

- Andrea Catarci Assessore al decentramento, partecipazione e servizi al territorio per la città dei 15 minuti

- Barbara Funari, Assessore alle Politiche Sociali e alla Salute.

- Miguel Gotor, Assessore alla cultura

- Monica Lucarelli Assessore alle Attività produttive e Pari opportunità

- Alessandro Onorato Assessore al Turismo, Grandi Eventi e Sport

- Eugenio Patanè Assessore ai Trasporti

- Claudia Pratelli Assessore alla Scuola, Formazione e Lavoro

- Ornella Segnalini Assessora ai Lavori Pubblici e alle Infrastrutture

- Tobia Zevi Assessore al Patrimonio e Politiche abitative

- Maurizio Veloccia – Assessore all’Urbanistica

- Assemblea Capitolina 2021

- Presidenti, Giunte, Consiglieri Municipi dal 2021

- Roma Capitale e CittàMetropolitana

- Le aziende partecipate del Comune di Roma

- Comune di Roma leggi norme e regolamenti

- La consiliatura Gualtieri dal 2021

- Elezioni a Roma

- Regione Lazio

- ISTITUZIONI

- PoliticaLab

- iDOSSIER

- Autonomia Regionale Differenziata, cronologia e materiali

- Modifiche al PRG di Roma

- PianoCasa/Legge rigenerazione urbana Lazio

- Progetto Porto turistico – crocieristico di Fiumicino – cronologia e materiali

- Affittacamere, case per vacanze, B&B a Roma e nel Lazio – cronologia e materiali

- Lago ex SNIA Viscosa – V Municipio

- Ex clinica Villa Bianca Cronologia

- Stadio Flaminio – II Municipio cronologia

- Circolo Poste e sotto ponte della Musica – cronologia e materiali

- Lago e area ex SNIA Viscosa – V municipio

- Regolamento del Verde di Roma

- PTPR – Piano Territoriale Paesaggistico Regionale (del Lazio)

- PatrimonioComune cronologia materiali

- PUP Piano Urbano Parcheggi cronologia materiali

- ProgettoFlaminio

- DecretoTrasparenza

- V.I.A. Valutazione Impatto Ambientale

- Stadio Tor di valle cronologia

- Pineta di Villa Massimo (Punto Verde Infanzia) II Municipio

- Il Parco di Centocelle – V Municipio – cronologia e materiali

- Pianidizona

- PVQ

- MetroC

- Torri dell’EUR

- ForteTrionfale

- Autorecupero a scopo abitativo del patrimonio pubblico esistente – cronologia e materiali

- ATAC – cronologia e materiali

- BastaCartelloni

- iQuaderni

- Stadio Pietralata

- Modifiche al PRG

- Regolamento del Verde

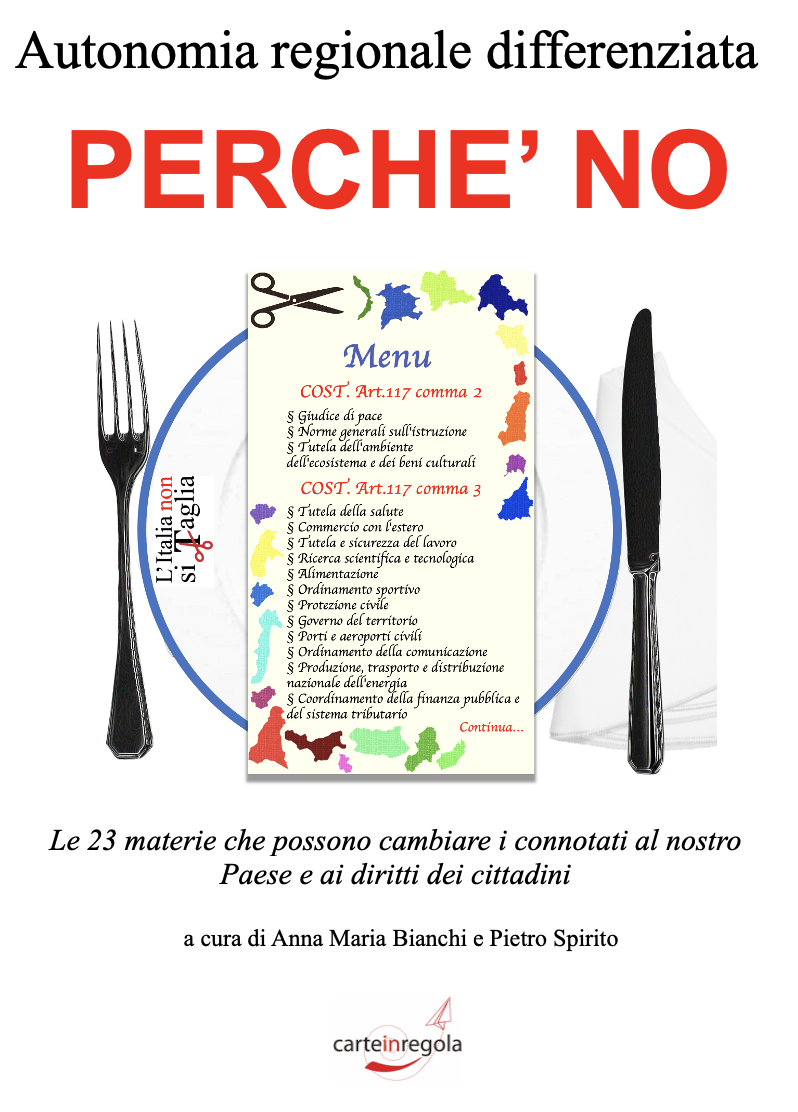

- L’Italia non si taglia

- Giubileo 2025

- Urbanistica del Lazio 2023-25

- Regione Lazio, PL urbanistica, Art. 1 (governo del territorio- interventi in zona agricola)

- Regione Lazio, PL urbanistica, Art. 2 (rigenerazione urbana)

- Regione Lazio, PL urbanistica, Art. 6 (valorizzazione degli immobili di proprietà pubblica)

- Regione Lazio, PL urbanistica, Art. 7 (procedure di Valutazione Ambientale)

- Regione Lazio, PL urbanistica, Art. 10 (strumenti attuativi)

- Regione Lazio, PL urbanistica, Art. 13

- Regione Lazio, PL urbanistica, Art. 15 (attività estrattive)

- Regione Lazio, PL urbanistica, Art. 16 (aree sviluppo industriale)

- Regione Lazio, PL urbanistica, Art. 17 (edilizia agevolata)

- Regione Lazio, PL urbanistica, Art. 17 (edilizia agevolata)

- Home

- Chi siamo

- - Chi siamo – il laboratorio

- - Iscriviti alla newsletter

- - Il Manifesto di Carteinregola

- - Le nostre regole

- - Rete di Carteinregola

- - Le iniziative di Carteinregola dal dicembre 2020

- - Tutte le nostre iniziative

- - - Fatti sentire! Impariamo a usare gli strumenti di comunicazione

- - - Censimento

- - - - Comitatiromani

- - - Piediperterra

- - - - Piediperterra a Dragona e Dragoncello

- - - - - 1. Parco del Drago: appunti per una introduzione storica

- - - - - 2. Dragoncello: storia del Parco del Drago, Convenzione urbanistica PRU e progetti

- - - - - 3. Storia di Dragona

- - - - - 4. Dragona: il Museo D. Agostinelli

- - - - - 5. Dragona: il Punto Verde Qualità

- - - - - 6. Dragona: La stazione Acilia sud Dragona

- - - - - 7. Dragona – Dragoncello: Dorsale mare Tevere

- - - - - 8. Progetto Casale Dragoncello

- - - - Piediperterra a San Lorenzo – Municipio II Roma

- - - - Piediperterra a Testaccio

- - - - Piediperterra a Casal Bertone – 5 luglio 2018

- - - - Piediperterra 1

- - - - Piediperterra 2 a Morena

- - - - Spiazmoli! Piediperterra all’EUR 3- Spiazziamoli! IL PERCORSO

- - - - Piedi per terra al Torrino sud il 20 gennaio 2017

- - - - Piediperterra a Primavalle -28 aprile 2018

- - - Diario Presidio Campidoglio 2012-2013

- - - Dieci parole dell’ urbanistica

- - - - PTPR – il seminario del 1 luglio 2019

- - Rassegna stampa

- Laboratorio

- - associazione

- - - Gruppo lavoro mobilità

- - - - Rete ferroviaria metropolitana e rete di superficie

- - - - GRUPPO STUDIO Rete intermodale e nodi di interscambio

- - - - Scenari PUMS rete ferro metro tramviaria

- - - - TRAM

- - - - METROPOLITANE

- - - - nuovo contratto ATAC 2025-2027

- - - - Mobilità – infomobilità

- - - - Gruppo lavoro Mobilità – ciclabilità

- - - indirizzario

- - - Calendario

- - - - Calendario – eventi

- - - la Biblioteca di Carteinregola – per i soci

- - STRUMENTI PER CITTADINI ATTIVI

- - - Gestire il Calendario Gmail

- - - - Istruzioni condividere calendario Gmail

- - - - istruzioni gestione account posta Gmail – gruppi di contatti

- - - - Istruzioni per creare una pagina Facebook

- La Mappa

- - schema per le schede

- Calendario

- Istituzioni

- - ISTITUZIONI

- - - Governo Italiano

- - - - Governo Italiano

- - - ROMA CAPITALE

- - - - La consiliatura Gualtieri dal 2021

- - - - - Deliberazioni dell’Assemblea Capitolina dal 2021

- - - - - Deliberazioni della Giunta Gualtieri dal 2021

- - - - - Roberto Gualtieri Sindaco

- - - - - La Giunta Capitolina Gualtieri 2021

- - - - - - Silvia Scozzese Vicesindaco e Assessore al Bilancio

- - - - - - Sabrina Alfonsi, Assessore ai Rifiuti, Ambiente e Agricoltura

- - - - - - Andrea Catarci Assessore al decentramento, partecipazione e servizi al territorio per la città dei 15 minuti

- - - - - - Barbara Funari, Assessore alle Politiche Sociali e alla Salute.

- - - - - - Miguel Gotor, Assessore alla cultura

- - - - - - Monica Lucarelli Assessore alle Attività produttive e Pari opportunità

- - - - - - Alessandro Onorato Assessore al Turismo, Grandi Eventi e Sport

- - - - - - Eugenio Patanè Assessore ai Trasporti

- - - - - - Claudia Pratelli Assessore alla Scuola, Formazione e Lavoro

- - - - - - Ornella Segnalini Assessora ai Lavori Pubblici e alle Infrastrutture

- - - - - - Tobia Zevi Assessore al Patrimonio e Politiche abitative

- - - - - - Maurizio Veloccia – Assessore all’Urbanistica

- - - - - Assemblea Capitolina 2021

- - - - - - Commissioni capitoline 2021

- - - - - Presidenti, Giunte, Consiglieri Municipi dal 2021

- - - - Roma Capitale e CittàMetropolitana

- - - - Le aziende partecipate del Comune di Roma

- - - - Comune di Roma leggi norme e regolamenti

- - - - - Il nuovo Statuto di Roma Capitale

- - - Elezioni a Roma

- - - - Istruzioni per aderire alla Carta del candidato trasparente

- - - - Roma 2021 – candidati liste programmi materiali

- - - Regione Lazio

- - - - Elezioni Lazio 2023 – risultati ed eletti

- - - - - Le risposte dei partiti alle richieste di Carteinregola per le elezioni regionali 2023

- PoliticaLab

- iDOSSIER

- - Autonomia Regionale Differenziata, cronologia e materiali

- - Modifiche al PRG di Roma

- - PianoCasa/Legge rigenerazione urbana Lazio

- - Progetto Porto turistico – crocieristico di Fiumicino – cronologia e materiali

- - Affittacamere, case per vacanze, B&B a Roma e nel Lazio – cronologia e materiali

- - Lago ex SNIA Viscosa – V Municipio

- - Ex clinica Villa Bianca Cronologia

- - Stadio Flaminio – II Municipio cronologia

- - Circolo Poste e sotto ponte della Musica – cronologia e materiali

- - Lago e area ex SNIA Viscosa – V municipio

- - Regolamento del Verde di Roma

- - - Regolamento del Verde e del Paesaggio urbano – Domande & Risposte

- - PTPR – Piano Territoriale Paesaggistico Regionale (del Lazio)

- - PatrimonioComune cronologia materiali

- - PUP Piano Urbano Parcheggi cronologia materiali

- - - PUP – riepilogo Delibera n.79/20017 con espunzioni

- - ProgettoFlaminio

- - DecretoTrasparenza

- - - FOIA –

- - V.I.A. Valutazione Impatto Ambientale

- - Stadio Tor di valle cronologia

- - Pineta di Villa Massimo (Punto Verde Infanzia) II Municipio

- - Il Parco di Centocelle – V Municipio – cronologia e materiali

- - Pianidizona

- - - Tutti i PDZ (dal sito del Comune di Roma)

- - PVQ

- - - PVQ: gli interventi

- - - - Punti verde qualità: gli atti pubblicati dal Comune

- - MetroC

- - Torri dell’EUR

- - ForteTrionfale

- - Autorecupero a scopo abitativo del patrimonio pubblico esistente – cronologia e materiali

- - ATAC – cronologia e materiali

- - - REFERENDUM ATAC 11 novembre 2018

- - BastaCartelloni

- - iQuaderni

- - - Migranti e rifugiati, cronologia e materiali

- - Stadio Pietralata

- - - Stadio della Roma a Pietralata – elaborati ed atti

- - - Stadio della Roma a Pietralata, il dossier con le osservazioni di Carteinregola

- - - - Stadio della Roma, non solo uno stadio (le osservazioni di Carteinregola 2.)

- - - - Stadio della Roma, quale verde pubblico (le osservazioni di Carteinregola 3.)

- - - - Stadio della Roma, la mobilità richiede importanti interventi e certezze (le osservazioni di Carteinregola 4.)

- Modifiche al PRG

- - Delibera di Adozione Modifiche Piano Regolatore 11 12 2024

- - Modifiche alle NTA del PRG: le osservazioni di Carteinregola 2025

- Regolamento del Verde

- - Regolamento del Verde -materiali

- L’Italia non si taglia

- - Podcast L’Italia nonsi taglia

- Giubileo 2025

- Urbanistica del Lazio 2023-25

- - Regione Lazio, PL urbanistica, Art. 1 (governo del territorio- interventi in zona agricola)

- - Regione Lazio, PL urbanistica, Art. 2 (rigenerazione urbana)

- - Regione Lazio, PL urbanistica, Art. 6 (valorizzazione degli immobili di proprietà pubblica)

- - Regione Lazio, PL urbanistica, Art. 7 (procedure di Valutazione Ambientale)

- - Regione Lazio, PL urbanistica, Art. 10 (strumenti attuativi)

- - Regione Lazio, PL urbanistica, Art. 13

- - Regione Lazio, PL urbanistica, Art. 15 (attività estrattive)

- - Regione Lazio, PL urbanistica, Art. 16 (aree sviluppo industriale)

- - Regione Lazio, PL urbanistica, Art. 17 (edilizia agevolata)