- Home

- Chi siamo

- Chi siamo – il laboratorio

- Iscriviti alla newsletter

- Il Manifesto di Carteinregola

- Le nostre regole

- Rete di Carteinregola

- Le iniziative di Carteinregola dal dicembre 2020

- Tutte le nostre iniziative

- Fatti sentire! Impariamo a usare gli strumenti di comunicazione

- Censimento

- Piediperterra

- Piediperterra a Dragona e Dragoncello

- 1. Parco del Drago: appunti per una introduzione storica

- 2. Dragoncello: storia del Parco del Drago, Convenzione urbanistica PRU e progetti

- 3. Storia di Dragona

- 4. Dragona: il Museo D. Agostinelli

- 5. Dragona: il Punto Verde Qualità

- 6. Dragona: La stazione Acilia sud Dragona

- 7. Dragona – Dragoncello: Dorsale mare Tevere

- 8. Progetto Casale Dragoncello

- Piediperterra a San Lorenzo – Municipio II Roma

- Piediperterra a Testaccio

- Piediperterra a Casal Bertone – 5 luglio 2018

- Piediperterra 1

- Piediperterra 2 a Morena

- Spiazmoli! Piediperterra all’EUR 3- Spiazziamoli! IL PERCORSO

- Piedi per terra al Torrino sud il 20 gennaio 2017

- Piediperterra a Primavalle -28 aprile 2018

- Piediperterra a Dragona e Dragoncello

- Diario Presidio Campidoglio 2012-2013

- Dieci parole dell’ urbanistica

- Rassegna stampa

- Laboratorio

- La Mappa

- Calendario

- Istituzioni

- ISTITUZIONI

- Governo Italiano

- ROMA CAPITALE

- La consiliatura Gualtieri dal 2021

- Deliberazioni dell’Assemblea Capitolina dal 2021

- Deliberazioni della Giunta Gualtieri dal 2021

- Roberto Gualtieri Sindaco

- La Giunta Capitolina Gualtieri 2021

- Silvia Scozzese Vicesindaco e Assessore al Bilancio

- Sabrina Alfonsi, Assessore ai Rifiuti, Ambiente e Agricoltura

- Andrea Catarci Assessore al decentramento, partecipazione e servizi al territorio per la città dei 15 minuti

- Barbara Funari, Assessore alle Politiche Sociali e alla Salute.

- Miguel Gotor, Assessore alla cultura

- Monica Lucarelli Assessore alle Attività produttive e Pari opportunità

- Alessandro Onorato Assessore al Turismo, Grandi Eventi e Sport

- Eugenio Patanè Assessore ai Trasporti

- Claudia Pratelli Assessore alla Scuola, Formazione e Lavoro

- Ornella Segnalini Assessora ai Lavori Pubblici e alle Infrastrutture

- Tobia Zevi Assessore al Patrimonio e Politiche abitative

- Maurizio Veloccia – Assessore all’Urbanistica

- Assemblea Capitolina 2021

- Presidenti, Giunte, Consiglieri Municipi dal 2021

- Roma Capitale e CittàMetropolitana

- Le aziende partecipate del Comune di Roma

- Comune di Roma leggi norme e regolamenti

- La consiliatura Gualtieri dal 2021

- Elezioni a Roma

- Regione Lazio

- ISTITUZIONI

- PoliticaLab

- iDOSSIER

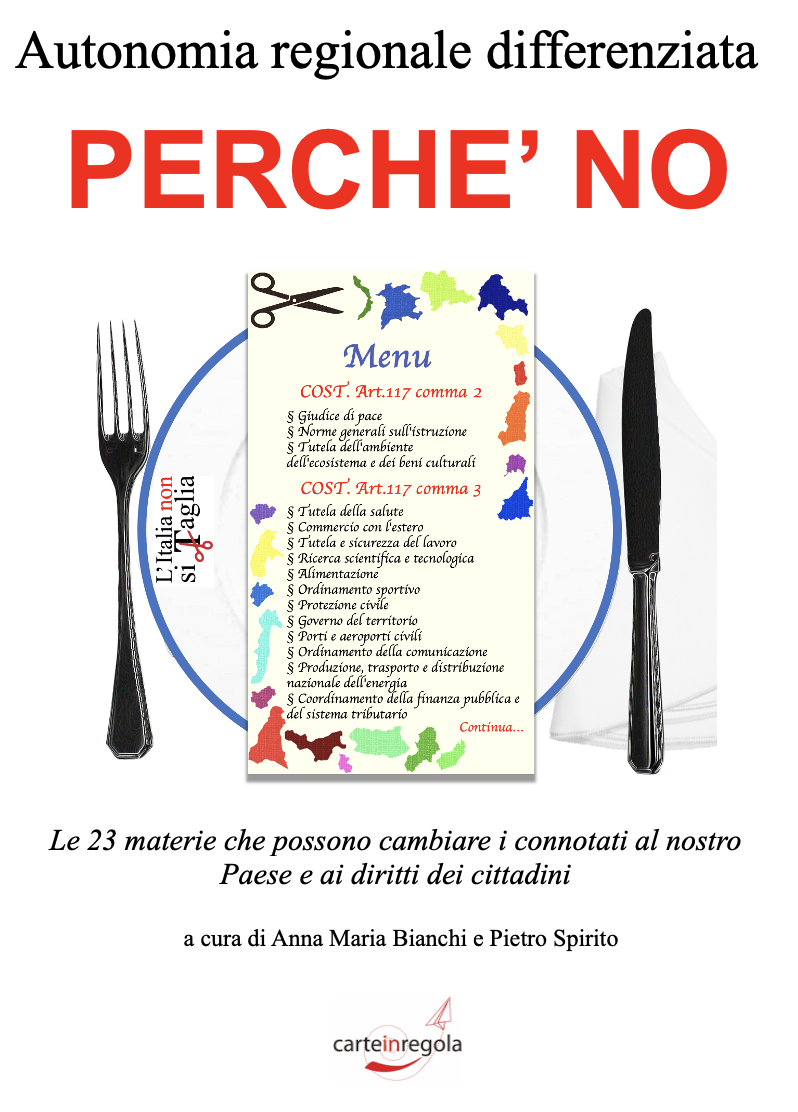

- Autonomia Regionale Differenziata, cronologia e materiali

- Modifiche al PRG di Roma

- PianoCasa/Legge rigenerazione urbana Lazio

- Progetto Porto turistico – crocieristico di Fiumicino – cronologia e materiali

- Affittacamere, case per vacanze, B&B a Roma e nel Lazio – cronologia e materiali

- Lago ex SNIA Viscosa – V Municipio

- Ex clinica Villa Bianca Cronologia

- Stadio Flaminio – II Municipio cronologia

- Circolo Poste e sotto ponte della Musica – cronologia e materiali

- Lago e area ex SNIA Viscosa – V municipio

- Regolamento del Verde di Roma

- PTPR – Piano Territoriale Paesaggistico Regionale (del Lazio)

- PatrimonioComune cronologia materiali

- PUP Piano Urbano Parcheggi cronologia materiali

- ProgettoFlaminio

- DecretoTrasparenza

- V.I.A. Valutazione Impatto Ambientale

- Stadio Tor di valle cronologia

- Pineta di Villa Massimo (Punto Verde Infanzia) II Municipio

- Il Parco di Centocelle – V Municipio – cronologia e materiali

- Pianidizona

- PVQ

- MetroC

- Torri dell’EUR

- ForteTrionfale

- Autorecupero a scopo abitativo del patrimonio pubblico esistente – cronologia e materiali

- ATAC – cronologia e materiali

- BastaCartelloni

- iQuaderni

- Stadio Pietralata

- Modifiche al PRG

- Regolamento del Verde

- L’Italia non si taglia

- Giubileo 2025

- Urbanistica del Lazio 2023-24

- Regione Lazio, PL urbanistica, Art. 1 (governo del territorio- interventi in zona agricola)

- Regione Lazio, PL urbanistica, Art. 2 (rigenerazione urbana)

- Regione Lazio, PL urbanistica, Art. 6 (valorizzazione degli immobili di proprietà pubblica)

- Regione Lazio, PL urbanistica, Art. 7 (procedure di Valutazione Ambientale)

- Regione Lazio, PL urbanistica, Art. 10 (strumenti attuativi)

- Regione Lazio, PL urbanistica, Art. 13

- Regione Lazio, PL urbanistica, Art. 15 (attività estrattive)

- Regione Lazio, PL urbanistica, Art. 16 (aree sviluppo industriale)

- Regione Lazio, PL urbanistica, Art. 17 (edilizia agevolata)

canlı casino siteleri online casino rottbet giriş rott bet güncel giriş

Widgetized Section

Go to Admin » Appearance » Widgets » and move Gabfire Widget: Social into that MastheadOverlay zone

La pigrizia cognitiva che fa il gioco delle fake news

(da Micromega Andrea Meneganzin 24 Marzo 2021)

La maggior parte degli utenti di piattaforme social non condividerebbe intenzionalmente fake news e misinformazione. È la conclusione di un recente studio che punta il dito contro la disattenzione e la noncuranza, anziché la faziosità o l’incapacità di discernere contenuti legittimi da notizie false e fuorvianti. Invitare a ragionare sull’accuratezza dei contenuti, anche attraverso stimoli integrati nel design delle piattaforme, potrebbe prevenire alla radice il problema. E potrebbe offrire un’alternativa alla rincorsa con fact-checking e censura – spesso problematica – di pseudonotizie già integrate nell’ecosistema informativo.

È dalle elezioni presidenziali USA del 2016 che la diffusione di disinformazione (falsità strutturate, destinate a ingannare) e misinformazione (notizie scorrette ma non costruite ad arte, seppur ugualmente fuorvianti) ha inaugurato una nuova nicchia d’attenzione nel dibattito pubblico. E si sono coniati nuovi lessemi, come la nota “post-verità” (post-truth) che l’Oxford English Dictionary a elevato a parola dell’anno 2016.

Più di recente, si è visto come la pandemia di COVID-19 abbia offerto gli elementi per creare una tempesta perfetta in grado di mettere a nudo il ruolo critico della diffusione di informazione in contesti disintermediati e altamente entropici come le piattaforme social. L’OMS ha battezzato col termine “infodemia” il fenomeno della sovrabbondanza di informazioni e la difficoltà per gli utenti di orientarsi tra fontinumerose e qualitativamente eterogenee, in un frangente in cui da una buona informazione dipendono scelte individuali e salute pubblica.

Gli autori di un recente studio guidato da Gordon Pennycook (University of Regina, Canada) e David Rand (MIT Sloan) sostengono che la narrativa della “post-verità” meriti di essere rivista. “Si potrebbe essere tentati di concludere che siamo nel mondo della post-verità – commentano Pennycook e Rand su Scientific American – dove le persone sono effettivamente incapaci di distinguere realtà da finzione, sono ostinatamente ignoranti e condividono di proposito falsità. Non si tratta di una questione da poco. Perché se così fosse, le nostre democrazie sarebbero in guai grossi e, forse, non ci rimarrebbe che accettare (o addirittura implorare) una severa censura delle falsità da parte delle aziende di social media”.

La ricerca da loro pubblicata qualche giorno fa sulla prestigiosa rivista Nature mette in discussione questa lettura: il problema dell’aumento di misinformazione online non avrebbe a che fare con la disposizione degli utenti nei confronti della verità, ma con la loro attenzione.

Lo studio

La ricerca affronta due nodi cruciali della corrente crisi infodemica. Il primo riguarda le ragioni per cui gli utenti condividono (in gergo, sharing) cattiva informazione – palesi falsità o notizie fuorvianti (iper-faziose). Il secondo riguarda le soluzioni per limitarne la diffusione. I ricercatori hanno osservato che la veridicità di una notizia influenza solo in piccola parte l’intenzione dell’utente di condividerla, ma, contrariamente a quanto si potrebbe pensare, ha un grande impatto sulle valutazioni riguardo l’accuratezza. Questo “scollamento” sembra suggerire che la condivisione di un contenuto non implichi che venga valutato come esatto. Tuttavia, la maggior parte dei partecipanti ha dichiarato che ritiene importante condividere solamente notizie accurate. Un’apparente contraddizione che è stata affrontata dai ricercatori in una serie di indagini sperimentali, alcune condotte nel contesto di Facebook, altre su Twitter.

In relazione alla prima questione – i motivi per cui viene condiviso un contenuto inesatto o fuorviante – si sono volute testare tre ipotesi tra loro alternative, secondo cui alla base (i) vi sarebbe una confusione su ciò che è accurato e ciò che non lo è; (ii) verrebbe data priorità ad altri fattori (ad esempio, schieramenti di parte); (iii) vi sarebbe una disattenzione verso l’accuratezza dell’informazione.

I risultati

In un primo esperimento, sono stati proposti ad un gruppo di 1015 soggetti (americani) titoli, frasi di apertura e immagini di 36 articoli realmente comparsi sulle piattaforme social. Di questi, metà erano favorevoli ai Repubblicani, l’altra metà ai Democratici; metà erano notizie interamente false, l’altra metà vere. Ai partecipanti è stato chiesto in maniera casuale di valutare o la veridicità dei titoli (condizione dell’accuratezza) o di indicare se avrebbero condiviso un tale contenuto (condizione della condivisione).

Riguardo l’accuratezza, si è visto che le notizie vere venivano valutate come accurate con frequenza significativamente più alta rispetto a quelle false e in proporzione maggiore rispetto alle valutazioni basate sull’orientamento politico. Lo schema s’inverte invece per la condivisione, dove la concordanza o la discordanza politica sono i principali predittori della volontà di cliccare sul tasto “Condividi”. Ad esempio, la notizia che “Oltre 500 migranti sono stati arrestati con indosso il giubbotto esplosivo” è stata valutata come accurata dal 15,7% dei Repubblicani coinvolti nello studio, ma ben il 51,1% ha dichiarato che l’avrebbe condivisa. Perché?

I ricercatori hanno avanzato l’ipotesi della disattenzione, l’idea cioè che l’accuratezza sia sì ritenuta importante, ma non influenzi i meccanismi di sharing perché il contesto delle piattaforme social canalizza l’attenzione degli utenti su altri fattori, come la volontà di attirare e compiacere sostenitori (followers) o di segnalare l’appartenenza a un gruppo.

Un altro esperimento è stato condotto su utenti reali di Twitter, che avevano condiviso contenuti provenienti da siti ritenuti altamente inaffidabili (Breitbart e Inforwars). Tramite messaggio privato, è stato chiesto loro di valutare l’accuratezza di una singola notizia (non politica), e per le successive 24 ore è stata monitorata la loro attività sulla piattaforma. Gli autori hanno così osservato che attraverso una semplice domanda – un intervento che non proponeva un nuovo contenuto né prescriveva un diverso comportamento – la qualità media delle fonti delle notizie condivise era notevolmente più alta (e i link a Breitbart ridotti). Lo stesso risultato si è riscontrato proponendo nell’esperimento contenuti su COVID-19.

“Spintarelle” o censura?

Le piattaforme social guardano (per ribadire l’ovvio) alla dimensione sociale, interazionale. Per questo motivo l’attenzione degli utenti è rivolta a produrre, replicare e interagire con contenuti che creano coinvolgimento – questo è ciò che l’algoritmo premia. In un singolo scorrimento di pollice (scrolling) l’utente medio si imbatte in un mix di notizie e altri contenuti a impatto emotivo (immagini di animali

domestici o di bambini) o contenuti satirici e ironici (meme): è molto semplice, sostengono gli autori, che l’attenzione venga dirottata dal considerare se si sta condividendo un’informazione corretta o meno. Da un punto di vista cognitivo, interverrebbe dunque un “pensiero pigro” (lazy thinking), non doloso, nella proliferazione di cattiva informazione in rete.

Ma questa non è necessariamente una brutta notizia. Se l’attuale design delle piattaforme ci distrae dall’accuratezza, esistono strumenti per invertire la tendenza. Pennycook e Rand sostengono che con dei nudges (“colpetti”, “spinte gentili”), come una semplice domanda o un avviso in una finestra automatica, è possibile riportare l’attenzione dei naviganti su accuratezza e veridicità. Organizzazioni della società civile e altri soggetti senza scopo di lucro potrebbero adottare un simile approccio, con inserzioni ad hoc per i soggetti più a rischio di misinformazione (persone in età avanzata non avvezze alle dinamiche del digitale o frequentatori di siti di disinformazione).

Se questa soluzione, già esplorata nell’ambito dell’economia comportamentale, è consapevolmente una forma di paternalismo libertario – le “buone” scelte vengono orientate, ma la libertà individuale rispettata – essa potrebbe rappresentare una valida alternativa alle problematiche, inefficienti, e polarizzanti strategie di censura da parte delle piattaforme stesse o di certificazione dell’affidabilità (da delegare a enti terzi) persino tramite contrassegno. Queste ultime, inoltre, rendono ineludibile la domanda: chi sorveglierebbe i sorveglianti?

Molto dibattuta è stata la recente decisione da parte di diverse piattaforme social di cancellare l’account di Donald Trump dopo i fatti di Capitol Hill. Tralasciando il fatto che in un contesto ideale questa drastica misura non dovrebbe spettare a un’azienda privata, una simile soluzione rispecchia un modello centralizzato di gestione dell’ecosistema informativo. Ciò che Pennycook e Rand sembrano suggerire è invece un modello distribuito, in cui ognuno, tramite scelta individuale (seppur “gentilmente incoraggiata”), fa la propria parte. “Contare fino a 10” e ragionare sulla bontà del contenuto che si ha di fronte è una perdita di tempo trascurabile nell’economia attentiva del singolo individuo, ma moltiplicato per gli oltre due miliardi di utenti di Facebook può produrre un effetto cumulativo con esiti affatto irrisori.

È evidente – gli stessi ricercatori ne sono consapevoli – che il complesso problema della dis-e misinformazione non verrà esaurito dalle strategie di nudging. Queste, al più, possono essere considerate come soluzioni complementari ad altre strategie preventive, dispendiose e di lungo periodo, come l’educazione e un’efficace comunicazione scientifica che riescano ad arginare la pigrizia cognitiva a cui siamo spesso soggetti. E che puntino a promuovere un senso critico nei confronti dei contenuti e a far fronte alla delicata crisi dell’autorevolezza che ha investito tutti gli ecosistemi informativi. Autorevolezza che, contrariamente a una narrativa comune, è propria di chi comunica, e non dei mezzi di comunicazione.

SOSTIENI MICROMEGA

Stiamo lavorando per completare il nuovo sito.

MicroMega rimane a disposizione dei titolari di copyright che non fosse riuscita a raggiungere. https://d08ca87330323bacddd17a231874ade7.safeframe.googlesyndication.com/safeframe/1-0-38/html/container.html